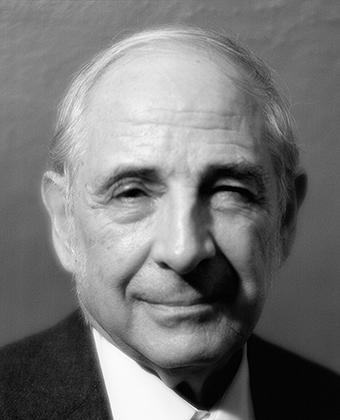

Джон Роджерс Сёрл (John Rogers Searle) — американский философ, представитель аналитического направления в философии (см. Аналитическая философия). В | |

Какую психологическую и философскую значимость следует нам приписать недавним усилиям по компьютерному моделированию познавательных способностей человека? Я считаю, что, отвечая на этот вопрос, полезно отличать «сильный» AI (как я это называю) от «слабого» или «осторожного» AI (Artificial Intelligence — Искусственный интеллект). Согласно слабому AI, основная ценность компьютера в изучении сознания состоит в том, что он даёт нам некий очень мощный инструмент. Например, он даёт нам возможность более строгим и точным образом формулировать и проверять гипотезы. Согласно же сильному AI, компьютер — это не просто инструмент в исследовании сознания; компьютер, запрограммированный подходящим образом, на самом деле и есть некое сознание в том смысле, что можно буквально сказать, что при наличии подходящих программ компьютеры понимают, а также обладают другими когнитивными состояниями. Согласно сильному AI, поскольку снабжённый программой компьютер обладает когнитивными состояниями, программы — не просто средства, позволяющие нам проверять психологические объяснения; сами программы суть объяснения. У меня нет возражений против притязаний слабого AI, во всяком случае, в этой статье. Моё обсуждение здесь будет направлено на притязания, которые я определил здесь как притязания сильного AI, именно: на притязание, согласно которому подходящим образом запрограммированный компьютер буквальным образом обладает когнитивными состояниями, и тем самым программы объясняют человеческое познание. Когда я далее буду упоминать AI, я буду иметь в виду сильный вариант, выраженный в этих двух притязаниях. Я рассмотрю работу Роджера Шэнка и его коллег в Йеле (Schank and Abelson, 1977), так как я знаком с ней больше, чем с другими подобными точками зрения, и потому что она представляет собой очень ясный пример того типа работ, которые я хотел бы рассмотреть. Но ничего в моём последующем изложении не зависит от деталей программ Шэнка. Те же аргументы приложимы Очень коротко, опуская разнообразные детали, можно описать программу Шэнка следующим образом: цель программы — смоделировать человеческую способность понимать рассказы. Для способности людей понимать рассказы характерно, что люди способны отвечать на вопросы о данном рассказе даже в тех случаях, когда даваемая ими информация не выражена в рассказе явным образом. Так, например, представьте, что вам дан следующий рассказ: «Человек зашёл в ресторан и заказал гамбургер. Когда гамбургер подали, оказалось, что он подгорел, и человек в гневе покинул ресторан, не заплатив за гамбургер и не оставив чаевых». И вот если вас спросят: «Съел ли человек гамбургер?», вы, видимо, ответите: «Нет, не съел». Точно так же, если вам предъявят следующий рассказ: «Человек зашёл в ресторан и заказал гамбургер; когда гамбургер подали, он ему очень понравился; и покидая ресторан, он перед оплатой по счёту дал официантке большие чаевые», и спросят: «Съел ли человек свой гамбургер?», вы, видимо, ответите: «Да, съел». И вот машины Шэнка могут точно так же отвечать на вопросы о ресторанах. В этих целях они обладают неким «представлением» («репрезентацией») той информации о ресторанах, какая бывает у людей и какая даёт людям возможность отвечать на подобные вопросы, когда им предъявлен некий рассказ, вроде тех, что приведены выше. Когда машине предъявляют рассказ и затем задают вопрос, она распечатает такой ответ, какой мы ожидали бы от человека, которому предъявлен подобный рассказ. Приверженцы сильного AI утверждают, что в этой последовательности вопросов и ответов машина не только моделирует некую человеческую способность, но что, кроме того:

Мне, однако, представляется, что работа Шэнка [1] никоим образом не подкрепляет ни одно из этих двух утверждений, Любую теорию сознания можно проверить, например, так: задаться вопросом, что бы это означало, что моё сознание на самом деле функционирует в соответствии с теми принципами, о которых данная теория утверждает, что в соответствии с ними функционируют все сознания. Приложим этот тест к программе Шэнка с помощью следующего Gedankenexperiment [2]. Представим себе, что меня заперли в комнате и дали некий массивный текст на китайском языке. Представим себе далее, что я не знаю ни письменного, ни устного китайского языка (так оно и есть на самом деле) и что я не уверен даже, что распознал бы китайский письменный текст в качестве такового, сумев отличить его, скажем, от японского письменного текста или от каких-нибудь бессмысленных закорючек. Для меня китайское письмо как раз и представляет собой набор бессмысленных закорючек. Представим себе далее, что вслед за этой первой китайской рукописью мне дали вторую китайскую рукопись вместе с набором правил сопоставления второй рукописи с первой. Правила эти на английском языке, Представьте себе теперь, что мне дали третью китайскую рукопись вместе с некоторыми инструкциями, — вновь на английском языке, — дающими мне возможность сопоставлять элементы этой третьей рукописи с первыми двумя, и эти правила учат меня, как в ответ на те или иные формальные символы из третьей рукописи выдавать определённые китайские символы, имеющие определённые очертания. Люди, которые дали мне все эти символы, называют первый текст «рукописью», второй — «рассказом», а третий — «вопросами», но я всех этих названий не знаю. Кроме того, они называют символы, которые я выдаю в ответ на третий текст, «ответами на вопросы», а набор правил на английском языке, который они дали мне, — «программой». Чтобы слегка усложнить эту историю, вообразите себе, что эти люди также дали мне некие рассказы на английском языке, которые я понимаю, и они задают мне вопросы на английском языке об этих рассказах, Представьте себе также, что после некоторого промежутка времени я так набиваю руку в выполнении инструкций по манипулированию китайскими символами, а программисты так набивают руку в писании программ, что при взгляде со стороны — то есть с точки зрения какого-либо человека, находящегося вне комнаты, в которой я заперт, — мои ответы на вопросы абсолютно неотличимы от ответов настоящих носителей китайского языка. Никто не сможет сказать, — если он видел только мои ответы, — что я ни слова не говорю И вот претензии сильного AI состоят в том, что программированный компьютер понимает рассказы и его программа в некотором смысле объясняет человеческое понимание. Но мы теперь можем рассмотреть эти претензии в свете нашего мысленного эксперимента.

Я не показал, что это утверждение ложно, но в данном примере оно определённо должно казаться неправдоподобным. А той правдоподобностью, которой оно всё же обладает, оно обязано предположению, будто мы можем построить программу, которая будет иметь те же входы и выходы, что и носители языка, и вдобавок мы исходим из Допущения, что для носителей языка имеется такой уровень описания, на котором они также являются инстанциациями программы. На основе данных двух утверждений мы допускаем, что даже если программа Шэнка не исчерпывает всего, чтобы мы могли бы узнать о понимании, она, возможно, есть хотя бы часть этого. Я допускаю, что это эмпирически возможно, но пока никто не привёл ни малейшего основания, чтобы могли полагать, что это истинно, мой пример наводит на мысль, — хотя, конечно, и не доказывает, — что компьютерная программа попросту не имеет никакого отношения к моему пониманию рассказа. В случае китайского текста у меня есть всё, что может вложить в меня искусственный интеллект посредством программы, но я ничего не понимаю; в случае английского текста я понимаю все, но пока что нет никаких оснований думать, что моё понимание имеет Они наверняка не составляют достаточных условий, и не было приведено ни малейшего основания считать, что они составляют необходимые условия или хотя бы вносят Но что же У меня были случаи представить этот пример некоторым людям, работающим в области AI, и, что интересно, они, Но сначала я хочу упредить некоторые распространённые недоразумения насчёт «понимания»: в ряде из этих дискуссий можно найти множество причудливых толкований слова «понимание». Мои критики указывают, что есть много различных степеней понимания; что «понимание» — это не простой двухместный предикат; что есть различные виды и уровни понимания, и часто даже закон исключённого третьего невозможно простым образом приложить к утверждениям формы «х понимает y»; что во многих случаях вопрос, понимает ли Имеются ясные случаи, в которых можно буквально говорить о понимании, и ясные случаи, в которых о нём нельзя говорить; и мне для моей аргументации в этой статье только и нужны эти два вида случаев [3]. Я понимаю рассказы на английском языке; в меньшей степени я понимаю рассказы Но Ньюэлл и Саймон (1963) пишут, что познание, которое они атрибутируют машинам, есть в точности то познание, которое присуще людям. Мне нравится прямота этой претензии, и именно эту претензию я буду рассматривать. Я буду аргументировать, что в буквальном смысле слова программированный компьютер понимает ровно столько, сколько автомобиль и счётная машинка, то есть ровным счётом ничего. Понимание чего бы то ни было компьютером не просто частично или неполно (подобно моему пониманию немецкого языка); оно попросту равно нулю. А теперь рассмотрим ответы. 1. Ответ от систем (Беркли)«Это правда, что тот человек, который заперт в комнате, не понимает рассказа, но дело в том, что он всего лишь часть некоей цельной системы, и эта система понимает рассказ. Перед ним лежит гроссбух, в котором записаны правила, у него имеется стопка бумаги и чернила, чтобы делать вычисления, у него есть «банки данных» — наборы китайских символов. И вот понимание приписывается не просто индивиду; оно приписывается всей этой системе, частью которой он является». Мой ответ теории систем очень прост: позвольте вашему индивиду интериоризовать все эти элементы системы. Пусть он выучит наизусть все правила из гроссбуха и все банки данных — все китайские символы, и пусть делает вычисления в уме. Тогда индивид будет воплощать в себе всю систему. Во всей системе не останется ничего, что он не охватил бы в себе. Мы можем даже отбросить комнату и допустить, что он работает под открытым небом. Всё равно он абсолютно не понимает китайский язык, и тем более этот язык не понимает система, ибо в системе нет ничего, чего не было бы в нём. Если он не понимает, то система никаким образом не сможет понимать, ибо эта система — всего лишь часть его. На самом деле, мне неловко давать даже такой ответ представителям теории систем, ибо эта теория кажется мне слишком неправдоподобной, чтобы начинать с неё. Её идея состоит в том, что если некий человек не понимает китайского языка, то Ту подсистему этого человека, которая ответственна за манипуляцию с формальными символами китайского языка, не следует смешивать с его подсистемой английского языка. Таким образом, в этом человеке на самом деле оказываются две подсистемы: одна понимает английский язык, а другая — китайский, и «Всё дело в том, что эти две системы мало как связаны друг с другом». Но я хочу ответить, что не только они мало связаны друг с другом, но между ними нет даже отдалённого сходства. Та подсистема, которая понимает английский язык (допустим, что мы позволили себе на минуту разговаривать на этом жаргоне «подсистем») знает, что наши рассказы суть о ресторанах и поедании гамбургеров, она знает, что ей задают вопросы о ресторанах и что она отвечает на эти вопросы, используя все свои возможности, делая различные выводы из содержания рассказа, и так далее. Но китайская система ничего этого не знает. Тогда как английская система знает, что «hamburgers» указывает на гамбургеры, китайская под система знает лишь, что за Весь смысл нашего исходного примера состоял в том, чтобы аргументировать, что такой манипуляции символами самой по себе недостаточно для понимания китайского языка в каком бы то ни было буквальном смысле, потому что человек может рисовать Спросим себя, какова основная мотивация ответа от теории систем; какие независимые основания имеются, как предполагается, чтобы утверждать, что агент должен иметь в себе некую подсистему, которая понимает (в буквальном смысле слова «понимать») рассказы на китайском языке? Насколько я могу судить, единственное основание состоит в том, что в нашем примере у меня имеются те же самые вход и выход, что у настоящих носителей китайского языка, и программа, приводящая от входа к выходу. Но вся суть наших примеров состояла в том, чтобы попытаться показать, что этого недостаточно для понимания — в том смысле слова «понимание», в каком я понимаю рассказы на английском языке, ибо человек, а стало быть, и набор систем, вместе составляющих человека, могут обладать правильной комбинацией входа, выхода и программы и всё же ничего не понимать — в том относящемся к делу буквальном смысле слова «понимать», в каком я понимаю английский язык. Единственная мотивация утверждения, что во мне должна быть некая подсистема, понимающая китайский язык, состоит в том, что я имей некую программу Наш пример показывает, что может случиться так, что есть две «системы» — обе успешно проходят тест Тьюринга, но лишь одна из них действительно понимает; и никудышным контраргументом было бы сказать, что раз обе успешно проходят тест Тьюринга, обе должны понимать, поскольку это утверждение не согласуется с аргументом, гласящим, что та система во мне, которая понимает английский язык, обладает Кроме того, ответ от теории систем, Это последнее соображение связано с некоторыми независимыми проблемами в сильном AI и имеет смысл отвлечься на минуту, чтобы разъяснить их. Если сильный AI хочет быть отраслью психологии, он должен уметь отличать действительно ментальные системы от тех, что ментальными не являются. Он должен отличать принципы, на которых основывается работа сознания, от принципов, на которых основывается работа нементальных систем; в противном случае он не даст нам никаких объяснений того, что же такого специфически ментального в ментальном. И дистинкция «ментальное — нементальное» не может зависеть только от точки зрения внешнего наблюдателя — она должна быть внутренне присущей самим системам; иначе любой наблюдатель имел бы право, если бы пожелал, трактовать людей как нементальные феномены, а, скажем, ураганы — как ментальные Но очень часто в литературе по AI эта дистинкция смазывается таким образом, что в конечном счёте это смазывание может оказаться фатальным для претензий AI быть когнитивным исследованием. Маккарти, например, пишет: «Можно сказать, что такие простые машины, как термостаты, обладают убеждениями (beliefs), и обладание убеждениями присуще, кажется, большинству машин, способных решать задачи» (McCarthy 1979). Всякий, кто считает, что сильный AI имеет шанс стать теорией сознания, должен поразмыслить над импликациями этого замечания. Нас просят принять в качестве открытия, сделанного сильным AI, что кусок металла на стене, употребляемый нами для регулирования температуры, обладает убеждениями в точности в том же самом смысле, в каком мы, наши супруги и наши дети обладают убеждениями, и более того — что «большинство» других машин в комнате: телефон, магнитофон, калькулятор, выключатель лампочки — также обладают убеждениями в этом буквальном смысле. В цели данной статьи не входит аргументировать против замечания Маккарти, так что я просто без аргументации выскажу следующее. Исследование сознания начинается с таких фактов, как то, что люди обладают убеждениями, а термостаты, телефоны и счётные машинки не обладают. Если вы получаете теорию, отрицающую этот факт, то это означает, что вы построили контрпример данной теории, и она ложна. Создаётся впечатление, что те люди, работающие в AI, которые пишут такие вещи, думают, что могут легко отбросить их, ибо на самом деле не принимают их всерьёз, и они не думают, что другие примут их всерьёз. Я же предлагаю принять их всерьёз — хотя бы на минуту. Поразмыслите напряжённо в течение одной минуты, что именно необходимо, чтобы установить, что вот этот кусок металла, висящий на стене, обладает настоящими убеждениями: убеждениями с направлением соответствия, пропозициональным содержанием и условиями выполнимости; убеждениями, могущими быть сильными или слабыми; нервными, тревожными или безмятежными убеждениями; догматическими, рациональными или суеверными убеждениями; слепой верой или сомневающимся познанием; убеждениями какого угодно рода. Термостат — не кандидат на обладание такими убеждениями. Равно как и желудок, печень, счётная машинка или телефон. Однако раз мы принимаем эту идею всерьёз, заметьте, что истинность его была бы фатальной для претензий сильного AI быть наукой о сознании. Ибо теперь сознание — повсюду. 2. Ответ от робота (Йейл)«Предположим, мы написали программу, отличную от программы Шэнка. Предположим, мы поместили компьютер внутрь некоего робота, и этот компьютер не просто воспринимал бы формальные символы на входе и выдавая бы формальные символы на выходе, а на самом деле руководил бы роботом так, что тот делал бы нечто очень похожее на сенсорное восприятие, хождение, движение, забивание гвоздей, еду и питье — в общем, всё что угодно. Этот робот, к примеру, имел бы встроенную телекамеру, которая давала бы ему возможность «видеть», он имел бы руки и ноги, которые давали бы ему возможность «действовать», и всё это управлялось бы его компьютерным «мозгом». Такой робот, в отличие от компьютера Шэнка, обладал бы настоящим пониманием и другими ментальными состояниями». Первое, на что следует обратить внимание в ответе от робота, вот что: этот ответ молчаливо соглашается с тем, что понимание — вопрос не только манипуляций с формальными символами, ибо этот ответ добавляет некий набор причинных отношений с внешним миром. Но ответ на ответ от робота заключается в том, что добавление таких «перцептуальных» или «моторных» способностей ничего не добавляет к исходной программе Шэнка в том, что касается понимания в частности или интенциональности вообще. Чтобы увидеть это, обратите внимание на то, что тот же самый мысленный эксперимент приложим Предположим далее, что некоторые китайские символы, приходящие ко мне от телекамеры, встроенной в робота, и другие китайские символы, которые выдаю я, служат для того, чтобы включать моторы, встроенные в робота, так чтобы двигались ноги и руки робота, но я ничего этого не знаю. Важно подчеркнуть, что я делаю только одно — манипулирую формальными символами: я не знаю никаких дополнительных фактов. Я получаю «информацию» от «перцептивного» аппарата робота и выдаю «инструкции» его моторному аппарату, ничего этого не зная. Я — гомункулус этого робота, но в отличие от традиционного гомункулуса, я не знаю, что происходит. Я не понимаю ничего, кроме правил манипулирования символами. И вот в этом случае я хочу сказать, что у нашего робота нет никаких интенциональных состояний; он двигается просто в результате функционирования своей электросхемы и её программы. И более того, инстанциируя эту программу, я не имей никаких интенциональных состояний соответствующего рода. Я только следую инструкциям о манипулировании формальными символами. 3. Ответ от моделирования работы мозга (Беркли и Массачусетсский технологический институт)«Предположим, мы построили программу, которая не репрезентирует информацию, имеющуюся у нас о мире, — вроде той информации, которая имеется в сценариях Шэнка, но которая моделирует действительную последовательность возбуждения нейронов в синапсах мозга настоящего носителя китайского языка, когда он понимает рассказы на китайском языке и даёт ответы на них. Машина принимает на входе китайские рассказы и вопросы к ним, моделирует структуру настоящего китайского мозга, когда он информационно обрабатывает эти рассказы, и выдаёт на выходе китайские ответы. Мы можем даже вообразить, что эта машина оперирует не одной-единственной последовательно действующей программой, а целым набором параллельно действующих программ — подобно тому, как, видимо, функционирует настоящий мозг человека, когда он информационно обрабатывает естественный язык. И вот в этом случае мы наверняка должны были бы сказать, что наша машина понимает рассказы; а если мы откажемся признать это, то не должны ли мы будем также отрицать, что настоящие носители китайского языка понимают эти рассказы? На уровне синапсов чем отличались бы или чем могли бы отличаться программа компьютера и программа китайского мозга?» Прежде чем излагать свои возражения на этот ответ, я хотел бы отвлечься и заметить, что этот ответ странен в устах сторонника искусственного интеллекта (или функционализма и так далее): Базовая гипотеза состояла в том (или, по крайней мере, я предполагал, что она состоит в том), что имеется некий уровень ментальных операций, состоящих из вычислительных процессов над формальными элементами, и этот уровень представляет собой сущность ментального, и он может быть реализован в разнообразных мозговых процессах — точно так же, как любая компьютерная программа может быть реализована с помощью самых разных аппаратных устройств: согласно допущениям сильного AI, сознание относится к телу как программа относится к аппаратному устройству компьютера, и стало быть, мы в состоянии понимать сознание, не занимаясь нейрофизиологией. Если бы для того чтобы заниматься искусственным интеллектом, нам нужно было бы предварительно знать, как работает мозг, то нам не к чему было бы и утруждать себя занятиями искусственным интеллектом. Однако даже если мы подойдём столь близко к работе мозга, этого не будет достаточно, чтобы продуцировать понимание. Дабы увидеть это, вообразите, что вместо одноязычного человека, сидящего в комнате и тасующего символы, у нас есть человек, который оперирует неким сложным набором шлангов, связанных друг с другом с помощью клапанов. Когда этот человек получает китайские символы, он сверяется в программе, написанной на английском языке, какие клапаны ему нужно открыть и какие закрыть. Каждое соединение шлангов соответствует некоему синапсу в китайском мозгу, и вся система устроена так, что после возбуждений всех нужных синапсов, то есть после отворачивания всех нужных кранов, на выходе всей этой последовательности шлангов выскакивают китайские ответы. Ну и где же в этой системе понимание? Она принимает на входе китайские тексты, моделирует формальную структуру синапсов китайского мозга и выдаёт китайские ответы на выходе. Но этот наш человек определённо не понимает китайского языка, и эти наши шланги не понимают китайского языка, и если мы соблазнились бы согласиться с взглядом, который я считаю нелепым, — именно взглядом, согласно которому Поскольку моделируется только формальная структура последовательности нейронных возбуждений в синапсах, то не моделируется та сторона функционирования мозга, которая как раз и имеет значение, именно: каузальные свойства мозга, его способность продуцировать интенциональные состояния. А то, что формальных свойств недостаточно для каузальных свойств, показывает пример с шлангами: здесь все формальные свойства налицо, но они отсечены от интересных для нас нейробиологических каузальных свойств. 4. Комбинированный ответ (Беркли и Стэнфорд)«Пусть каждый из трёх предыдущих ответов, возможно, не является абсолютно убедительным в качестве опровержения контрпримера с китайской комнатой; но если вы объедините все три ответа, то вместе они гораздо более убедительны и даже бесспорны. Вообразите робота, в черепной полости которого встроен имеющий форму мозга компьютер; вообразите, что этот компьютер запрограммирован всеми синапсами человеческого мозга; вообразите далее, что все поведение робота неотличимо от человеческого поведения; и вот взгляните на всю эту штуку как на единую систему, а не просто как на компьютер с входами и выходами. Наверняка в этом случае мы должны были бы приписать нашей системе Институтенциональность». Я полностью согласен, что в таком случае мы сочли бы, что рационально и даже неизбежно принятие гипотезы о том, что данный робот обладает интенциональностью, поскольку мы ничего больше не знали бы о нём. В самом деле, никакие иные элементы этой комбинации, кроме внешнего вида и поведения, не имеют значения. Если бы нам удалось построить робота, поведение которого было бы на протяжении крупного интервала времени неотличимо от человеческого поведения, мы атрибутировали бы ему интенциональность — до тех пор, пока не получили бы каких-либо оснований не делать этого. Нам не нужно было бы заранее знать, что его компьютерный мозг — формальный аналог человеческого мозга. Но я действительно не вижу, как это могло бы помочь претензиям сильного AI, и вот почему. Согласно сильному AI, инстанциирование формальной программы с подходящими входом и выходом представляет собой достаточное условие интенциональности — Предположим, что мы знаем, что поведение робота полностью объясняется тем фактом, что некий человек, сидящий внутри него, получает неинтерпретированные формальные символы от сенсорных рецепторов робота и посылает неинтерпретированные формальные символы его двигательным механизмам, и человек этот совершает свои манипуляции с символам в соответствии с неким набором правил. Предположим далее, что данный человек не знает всех этих фактов о роботе; всё, что он знает, — какие операции нужно совершать над тем или иным бессмысленным символом. В таком случае мы бы сочли робота хитроумно сконструированной механической куклой. Гипотеза о том, что эта кукла обладает сознанием, была бы теперь ничем не подкреплённой и излишней, ибо нет никаких оснований приписывать интенциональность этому роботу или системе, частью которой он является (кроме, разумеется, интенциональности человека при его манипулировании символами). Манипуляции с формальными символами продолжаются, выход правильным образом соответствует входу, но единственный действительный локус интенциональности — человек, сидящий в кукле, а он не знает ни одного из относящихся к делу интенциональных состояний; он, к примеру, не видит, что отражается в глазах робота, он не намеревается двигать рукой робота, и он не понимает ни одного из замечаний, которые делает робот или которые ему адресуются. И, по изложенным выше основаниям, ничего этого не делает та система, частями которой являются человек и робот. Чтобы понять это соображение, сопоставьте этот случай со случаями, в которых мы находим совершенно естественным приписывать интенциональность членам некоторых других видов приматов — например, обезьянам и таким домашним животным, как собаки. Оснований, по которым мы находим это естественным, грубо говоря, две: мы не можем понять поведение этих животных без приписывания им интенциональности, и мы видим, что эти звери сделаны из материала, похожего на тот, из которого сделаны мы сами: это — глаз, это — нос, а вот это — его кожа и так далее. При том, что поведение животного обладает связностью и последовательностью, а также при допущении, что в его основе лежит тот же самый каузальный материал, мы допускаем, что в основе поведения этого животного должны быть ментальные состояния, и эти ментальные состояния должны продуцироваться механизмами, сделанными из материала, подобного нашему материалу Мы наверняка сделали бы такие же допущения о роботе, если бы у нас не было оснований не делать их, но раз мы узнали, что его поведение есть результат формальной программы и действительные каузальные свойства физического вещества не имеют к этому отношения, мы отбросили бы допущение об интенциональности. (См, Multiple authors 1978.) Часто встречаются ещё два ответа на мой пример (и поэтому заслуживают обсуждения), но на самом деле и они бьют мимо цели. 5. Ответ от других сознаний (Йейл)«Откуда вы знаете, что другие люди понимают китайский язык или Это возражение заслуживает лишь короткой реплики. Обсуждаемая нами проблема состоит не в том, откуда я знаю, что у других людей имеются когнитивные состояния, 6. Ответ от нескольких обиталищ (Беркли)«Весь ваш аргумент исходит из предпосылки, что AI ведёт речь только об аналоговых и цифровых компьютерах. Но это всего лишь современное состояние технологии. Что бы ни представляли собой те каузальные процессы, которые, как вы говорите, существенны для интенциональности (при допущении, что вы правы), в конечном счёте мы научимся создавать устройства, обладающие этими каузальными процессами, и это будет искусственным интеллектом. Так что ваши аргументы никоим образом не направлены на способность искусственного интеллекта продуцировать и объяснять познание». На самом деле у меня нет возражений против этого ответа, разве что одно: он на самом деле тривиализует замысел сильного AI, переопределяя его как всё то, что искусственно продуцирует и объясняет познание. Важность же первоначальной претензии, заявленной от лица искусственного интеллекта, состояла в том, что она представляла собой точный вполне определённый тезис: ментальные процессы суть вычислительные процессы над формально определёнными элементами. Моя цель заключалась в том, чтобы оспорить этот тезис. Если же претензия переопределена так, что она более не совпадает с этим тезисом, то и мои возражения более неприложимы, потому что у нас в руках не остаётся никакой проверяемой гипотезы, к которой их можно было бы приложить. Вернёмся теперь к вопросу, на который я обещал попробовать ответить: в предположении, что в моём самом первом примере я понимаю английский язык и не понимаю китайский, и поэтому машина не понимает ни Я в принципе не вижу никаких оснований, почему бы мы не могли передать машине способность понимать английский или китайский языки, ибо в некотором важном смысле наши тела и наши мозги суть в точности такие же самые машины. Но с другой стороны я вижу очень сильные основания для утверждения, что мы не смогли бы передать такие способности машине в том случае, когда функционирование этой машины определено только в терминах вычислительных процессов над формально определёнными элементами; то есть когда функционирование машины определено как инстанциация некоей компьютерной программы. Не потому я способен понимать английский язык и имей ещё другие формы интенциональности, что я являюсь инстанциацией компьютерной программы (я, наверное, являюсь инстанциацией какого угодно числа компьютерных программ), но — насколько мы знаем — потому, что я являюсь организмом определённого рода с определённой биологической (то есть химической и физической) структурой, и эта структура, при определённых условиях, каузально способна продуцировать восприятие, действие, понимание, обучение и другие интенциональные феномены. И один аспект предлагаемого мной аргумента состоит в том, что лишь нечто такое, что обладает этими каузальными способностям и, могло бы обладать интенциональностью. Быть может, другие физические и химические процессы могли бы продуцировать в точности те же эффекты; быть может, к примеру, марсиане также обладают интенциональностью, но их мозги сделаны из иного вещества. Это — эмпирический вопрос, подобно вопросу о том, может ли фотосинтез осуществляться Но основной пункт предлагаемого мной аргумента состоит в том, что никакая чисто формальная модель никогда сама по себе не будет достаточна для интенциональности, потому что формальные свойства сами по себе не конституируют интенциональность, и они сами по себе не обладают каузальными способностями, за исключением способности порождать, будучи инстанциированными, следующую стадию формализма, когда машина запущена и работает. И любые другие каузальные способности, имеющиеся у конкретных реализаций формальной модели, не имеют отношения к самой этой формальной модели, потому что мы всегда можем поместить эту же самую формальную модель в какую-нибудь иную реализацию, в которой эти каузальные свойства очевидным образом отсутствуют. Даже если носители китайского языка В функционировании мозга важна не та формальная тень, которую отбрасывает последовательность синапсов, а действительные свойства этих последовательностей. Все знакомые мне аргументы в пользу сильного варианта AI настаивают на том, чтобы нарисовать некий абрис, следуя тени, отбрасываемой познанием, и затем утверждать, что эти тени и суть та самая штука, тенями которой они являются. В заключение я хочу попытаться сформулировать некоторые общефилософские соображения, неявно присутствующие в моём аргументе. Для ясности я постараюсь построить изложение в виде вопросов и ответов и начну с одного избитого вопроса, а именно:

Ответ очевидным образом положителен. Мы как раз и есть такие машины.

В предположении, что возможно искусственно произвести машину с нервной системой, нейронами, обладающими аксонами и дендритами, и со всем прочим, в достаточной степени похожими на нашу нервную систему, наши нейроны и так далее, ответ на этот вопрос представляется опять же тривиально положительным. Если вы в состоянии точно продублировать причины, то вы в состоянии продублировать и следствия. И на самом деле, возможно, быть может, продуцировать сознание, интенциональность и всё такое прочее, используя

Если под «цифровым компьютером» мы понимаем любой предмет, имеющий такой уровень описания, на котором его можно корректно описать как инстанциацию компьютерной программы, то ответ, разумеется, опять же положителен, ибо мы суть инстанциации какого угодно числа компьютерных программ и мы можем мыслить.

Вот это,

Потому что манипуляция формальными символами сама по себе не обладает никакой интенциональностью; она лишена смысла; она даже не является манипуляцией символами, ибо эти символы ничего не символизируют. Используя лингвистический жаргон, можно сказать, что они имеют лишь синтаксис, но не имеют семантики. Такая интенциональность, которой, как кажется, обладает компьютер, существует единственно в мозгах тех людей, которые запрограммировали его и используют его, посылают нечто на вход и интерпретируют то, что появляется на выходе. Цель примера с китайской комнатой состояла в том, чтобы попытаться показать это, показав, что как только мы помещаем нечто в систему, которая на самом деле обладает интенциональностью (человек), и программируем эту систему формальной программой, то вы видите, что эта формальная программа не несёт никакой дополнительной интенциональности. Она ничего не прибавляет, например, к способности человека понимать китайский язык. Именно эта черта AI — различие между программой и реализацией, казавшаяся столь привлекательной, — оказывается фатальной для претензии на то, что моделирование может стать дублированием. Различие между программой и её реализацией в аппаратном устройстве компьютера, Визенбаум (Wiezenbaum, 1976: Начать с того, что камни, туалетная бумага, ветер и шланги — не те вещи, что могут быть наделены интенциональностью (ей могут быть наделены лишь предметы, обладающие теми же каузальными способностями, что и мозг), и хотя носитель английского языка сделан из подходящего для интенциональности материала, нетрудно видеть, что он не приобретает никакой дополнительной интенциональности, выучив наизусть программу, поскольку выучивание её наизусть не научит его китайскому языку;

На самом деле я не знаю ответа на этот вопрос. Идея, что компьютерные модели могут быть самими реальными вещами, должна была бы показаться подозрительной — прежде всего потому, что компьютер, во всяком случае, не ограничивается моделированием ментальных операций. Никому ведь не приходит в голову, что компьютерное моделирование пожарной тревоги может сжечь дотла соседние дома или что компьютерное моделирование ливня заставит нас всех промокнуть. Так почему же И тем не менее есть несколько оснований, почему должно было казаться, — а многим людям, возможно, и сейчас кажется, — что AI Первое (и, быть может, самое важное) основание — это путаница с понятием «обработка информации»: многие, занимающиеся когнитивной наукой, полагают, что мозг человека с его сознанием занят Компьютер, повторим, имеет синтаксис, но лишён семантики. Так, если вы напечатаете компьютеру: «Сколько будет Но в этом случае интерпретировать их вход и выход как информацию в обычном смысле этого слова приходится внешним наблюдателям. И тогда в терминах сходства процессов обработки информации не удастся установить сходство между компьютером и мозгом. Во-вторых, в большей части исследований по AI наличествуют остатки позиций бихевиоризма или функционализма. Поскольку подходящим образом программированные компьютеры могут иметь схемы входа и выхода, сходные со схемами входа и выхода у людей, у нас появляется соблазн постулировать у компьютеров ментальные состояния, сходные с человеческими ментальными состояниями. Но раз мы видим, что возможно и концептуально и эмпирически, чтобы система обладала человеческими способностями в некоей области, вовсе не обладая при этом интенциональностью, то мы должны суметь превозмочь этот соблазн. Мой настольный калькулятор обладает способностями к счёту, но не обладает интенциональностью, В-третьих, этот остаточный операционализм соединяется с остаточной формой дуализма; в сущности, сильный AI имеет смысл лишь в том случае, если принимается дуалистическое допущение о том, что там, где дело идёт о сознании, мозг не имеет значения. В сильном AI (а также Замысел состоит в том, чтобы воспроизвести и объяснить ментальное, конструируя программы, но вы можете осуществить этот замысел лишь в том случае, если сознание не только концептуально, но и эмпирически не зависит от мозга, ибо программа совершенно не зависит от той или иной реализации. Вы можете надеяться воспроизвести ментальное, конструируя и запуская программы, лишь в том случае, если вы полагаете, что сознание отделимо от мозга как концептуально, так и эмпирически (сильная форма дуализма), ибо программы должны быть независимы от мозга, а равно и от любых конкретных форм инстанциации. Если ментальные операции состоят в вычислительных операциях над формальными символами, то, следовательно, они никаким интересным образом не связаны с мозгом; единственная связь заключалась бы в том, что мозгу случилось быть одним из неопределённо большого числа типов машин, способных инстанциировать данную программу. Эта форма дуализма не совпадает с традиционной картезианской разновидностью, утверждающей, что есть субстанции двух родов, но это всё же картезианский дуализм в том смысле, что он настаивает на том, что то, что есть в сознании специфически ментального, не имеет внутренней связи с действительными свойствами мозга. Этот дуализм, лежащий в основе AI, маскируется тем, что литература по AI содержит многочисленные инвективы против «дуализма»; чего эти авторы,

В защиту данного дуализма выражается надежда, что мозг — это цифровой компьютер (кстати, первые компьютеры часто называли «электронными мозгами»). Однако это не поможет. Конечно, мозг — цифровой компьютер. Раз любой предмет — цифровой компьютер, отчего бы мозгу не быть им. Но всё дело в том, что каузальная способность мозга продуцировать интенциональность не может заключаться в том, что мозг инстанциирует некую компьютерную программу, ибо возьмите любую программу, и найдётся такой предмет, который инстанциирует эту программу, но тем не менее не имеет никаких ментальных состояний. В чём бы ни заключалось продуцирование мозгом интенциональности, оно не может заключаться в инстанциировании некоей программы, ибо никакая программа сама по себе недостаточна для интенциональности [5]. | |

Примечания | |

|---|---|

| |

Библиография | |

| |